在海量的信息中,AI算法帮助人们更快更准确地找到想要的内容;在AI的助力下,一座城市的交通得以更合理地规划布局;通过人脸识别AI,甚至可以指引走失者与家人团聚…… AI算法技术正给人们带来越来越多的便利,但同时,也带来不容忽视的挑战——算法偏见。

在近日一场由复旦大学新闻学院、复旦大学全球传播全媒体研究院举办的“智能传播与算法推荐”线上研讨会上,复旦大学计算机学院教授肖仰华指出,算法偏见不单单是算法本身的偏见,它在更广义上是指整个人工智能系统、平台对于某些任务产生一些局限性,导致结果存在一般意义上的偏见,可以归结为“技术上存在某种局限性,导致结果存在一定的偏见”。

那么,算法如何避免偏见呢?

肖仰华分析,第一是避免数据偏见。人工智能的模型都是由数据喂养,所以给它什么样的数据,就可能产生什么样的结果。例如闲聊类型的问答机器人,是根据大量的问答语料训练出来的。如果当你提供的是带有歧视性的对话语料,机器很可能学会带有歧视性的聊天。对于这类问题,肖仰华提出,需要在数据治理和管控方面下大功夫,要确保喂给机器数据本身是消除偏见的。

第二是避免模型自身所导致的偏见。人工智能技术的很多模型本质上是优化的问题,它有明确可量化的优化目标,不同的优化目标会导致不同倾向的结果。在模型构造的时,要做一些特征的设计,特征设计涉及到选择性问题,“我们可以关注这些特征,也可以关注那些特征,在做模型特征设计的时候我们也会带来一定的偏见。” 肖仰华说道。

第三个原因,与当前技术的瓶颈有关。肖仰华提到,技术不透明性,也会导致最终超出人们预期或是可控范围之外的一些结果,从而造成所谓的一些偏见。肖仰华建议,“将所表现的逻辑向大众公开,让大众知其然,还能知其所以然,就能在一定程度上解决对算法的担忧”。但需要注意的是,偏见是基于人而存在的,即使没有算法和技术,偏见都是始终存在的。

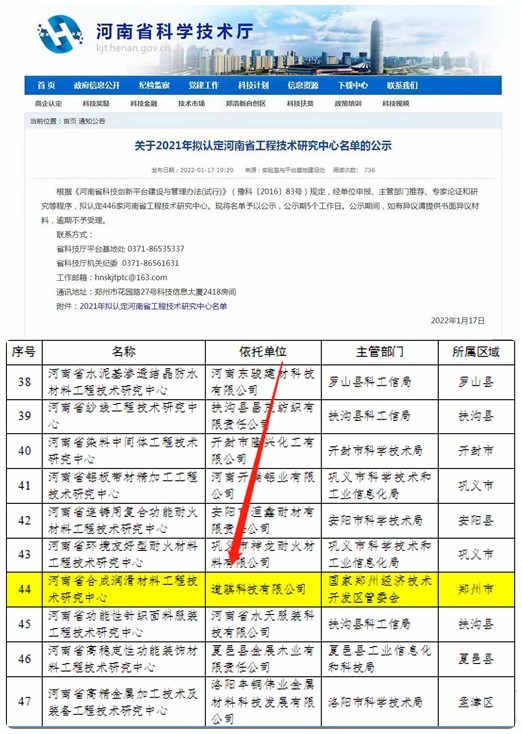

营业执照公示信息

营业执照公示信息