信息茧房只是一个假说。用户接触信息的渠道融合了人际传播、大众传播与网络自传播等各种平台,在个体维度形成真正的信息茧房实属难之又难。算法推荐成为信息茧房假说的背锅侠可以视为是新媒体批判脉络的延续,也是舆论建构的结果,本质上属于技术污名化的问题。

在现代社会,信息的指数级增长形成了巨量信息与人们有限的注意力之间的矛盾,这也可以称之为现代信息社会的主要矛盾。这个矛盾规限了信息传播的底层逻辑,认清这个主要矛盾,对于思考信息与人的关系,具有重要价值。

我们可以做个比较,以便于更清晰地认识这个矛盾。在信息稀缺状态,信息传播的主要逻辑是“人找信息”。我国1980前的几代人,不仅经历了物质稀缺,也体验过信息稀缺,对此应该都记忆深刻。但在信息过剩状态,传播的主要逻辑则变成了“信息找人”,所以近年来分众传播、精准传播等理念兴起,主要是为了适应寻找目标受众的需要。

但无论在哪个时代,信息与人的需求恰好匹配总是具有特别的价值。我们在各类名人传记中,经常可以看到传主如饥似渴地阅读各类书籍,进而实现命运逆转的故事,这就是信息与个体需求相匹配后所产生的价值裂变。但在信息过剩状态中,信息的过量供应造成的直接结果就是注意力的短缺,并在多元平台的竞逐之下形成了注意力竞争的格局。

在这种新格局下,如何在注意力的竞争中占据优势就成为信息生产者和分发平台关注的核心问题。为了有效回应这一问题,算法推荐技术应运而生。因此从功能上来看,算法推荐技术不过是为了实现海量信息与海量用户需求的有效匹配。

但从当下的舆论来看,算法推荐却似乎带着原罪的标签,被归为诸多信息传播问题中的罪魁祸首,算法黑箱、信息茧房、算法偏见、算法伦理等不断成为热议的公共话题和学术问题。但推荐算法是否就真的该背这个锅呢?我们可以从信息茧房问题入手,做个具体的讨论。

信息茧房概念源自美国学者桑斯坦在2002年出版的《网络共和国》一书。但从其后的应用来看,却成为一个颇具中国特色的概念。在Google Trends中,information cocoons一词近乎踪迹全无,而类似的概念filter bubbles或者echo chambers effect热度却居高不下。但在百度指数中,情况却恰恰相反,过滤气泡或回音室效应两个概念未被收录进百度指数,但信息茧房却屡成热搜。在学术界也存在类似的现象。北京师范大学的两位学者丁汉青、武沛颍在《“信息茧房”学术场域偏倚的合理性考察》一文中提到,截止到2020年2月,在web of science数据库里,西方学者关注信息茧房的论文只有一篇,而CNKI文献库,我国学者的研究数量却高达584篇。在这 584 篇文献中,有 133 篇同时含有 “算法” 与 “信息茧房” 两大关键词,272 篇虽未将 “算法” 作为关键词,但论述时提及 “算法”。这表明,算法推荐与 “信息茧房”被紧密关联起来。不仅如此,两位学者经分析发现,在这584篇的论文里,有500余篇的论文建立在信息茧房这个假说已经被证实的基础上,只有47篇是为了论证信息茧房这个假说是否成立。

但其实信息茧房只是一个假说。该假说的理论前提是用户的选择性接触理论,不过社交媒体中选择性接触机制确实比早期理论中所描述的“寻找支持或加强其已有观念的信息”行为更具层次性与复杂性。一方面,有不少研究已经开始关注该机制的层次问题,并将其运作过程进行拆分(Ohme & Mothes, 2020)。而我们团队的研究也发现,该机制受到包括注意力、情感、立场、信息热度等内外因素共同影响,这说明信息选择的影响路径是多维的。另一方面,当具有差异化特征的主体和信息作为前置条件时,信息选择的触发方向也非常复杂。具体而言,按照早期理论假设,立场越强烈其选择性接触倾向也应当越强烈。但我们的研究却发现,不同立场对选择性接触的作用方向呈现出偏差。

可以说,在社交媒体背景下,信息的选择性接触机制不再是传统理论描述的那种单一化、被动触发的条件反射行为,而成为了某种根据不同条件进行调整的主动行为。因此,从目前的研究来看,用户的选择性接触理论并不能推导出必然存在信息茧房现象。更何况在实际情况下,用户个体接触信息的渠道融合了人际传播、大众传播与网络自传播等各种平台,在个体维度形成真正的信息茧房实属难之又难。

我们还可以对信息茧房概念做个初步的知识考古式的分析。从起源来看,对信息类型单一化问题的研究早在桑斯坦的《网络共和国》之前就已经出现。麻省理工学院教授马歇尔·范·埃尔斯泰恩(Marshall Van Alstyne)和埃里克·布尔约尔松(Erik Brynjolfsson)在1997年发表的论文《电子社区:是全球村,还是网络巴尔干国家?》(Electronic Communities: Global Village or Cyberbalkans)中提出了“网络巴尔干化”的概念,意指网络已分裂为有各怀利益心机的繁多群类,且一个子群的成员几乎总是利用互联网传播或阅读仅可吸引本子群其他成员的信息或材料。因此,正如实际空间的分割可以分开地理群体一样,虚拟空间的分割或者网络巴尔干化,也可以分开利益群体。这就是说,平台分化、社群分化以及与之相伴的信息的单一化问题,早在推荐算法大行其道之前就已经成为一种典型问题。因此,算法不过是新媒体批判的一个新靶子而已。

在媒介发展史上,初生的新媒体面临的舆论环境一般不太友好,甚至经常受到大V的批判。例如,作为口语传播的捍卫者,苏格拉底也是文字传播的坚决批判者。他认为使用文字会让人“丧失检视语言的能力”,“丧失批判性和创造性思维能力”,认为书本会造成积极批判思考的短路,造就出仅拥有“虚妄智慧”的学子。现代电子传播兴起以后,文字传播则似乎变成了一种完美的传播形式,电子传播则被批判学者认为造成了大规模劣质信息的传播和娱乐化风潮,会消解文化中的深层意义。

算法推荐成为信息茧房假说的背锅侠可以视为是新媒体批判脉络的延续,也是舆论建构的结果,本质上属于技术污名化的问题。从当前舆论对推荐算法的污名化策略来看,主要有三种套路。首先是从个体维度入手,将推荐算法视为个体生命健康安全的直接威胁,通过恐惧诉求机制,激发受众的预防动机和自我保护行为。其次是从社会维度入手,将推荐算法视为社会安全的直接威胁,认为推荐算法将导致或加剧群体分化甚至群体对抗。第三是从文化维度入手,借用传统针对“技术恐惧”(Technophobia)的文化模因,通过对推荐算法负面影响的渲染来唤起人类社会文化中的对技术发展和现代化的隐忧。这种污名化说辞的大行其道意味着偏见、欺诈、消费者权益等传统议题被建构在更为中性的“技术框架”之中,这就形成一种“话语陷阱”,转移了公众对技术问题背后政经问题的关注,令整个社会将更多的注意力放在技术性议题上,遮蔽了实现公众信息福利过程中的核心问题,使得危害用户权益和公共利益的行为可以在技术框架的掩护下持续运作。

当然我们无意于替算法推荐卸责,而是主张围绕用户权益保护、公众信息福利等核心问题,在技术、资本、社会、个体以及各类权力组织的互动中与真正的社会问题进行有效对话,这样才能摆脱技术决定论的窠臼,跳出技术污名化形成的话语陷阱,击破各种打着算法名号的概念泡沫。

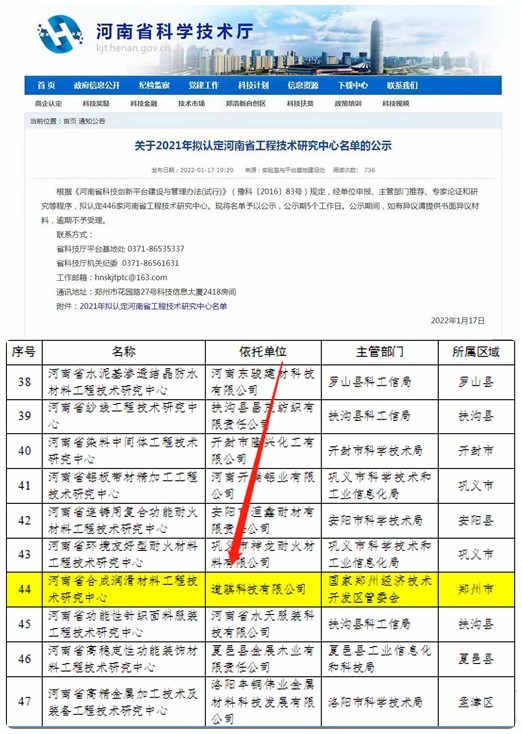

营业执照公示信息

营业执照公示信息